2016年7月的第一天,特斯拉终于搞了个大新闻。

特斯拉在官网的Blog中,公开了第一起因为使用Autopilot功能致死的交通事故,并把这起事故称为「ATragic Loss」。随后,Elon Musk在推特上转发了这条新闻,引起众多媒体纷纷报道。(注:「Autopilot」是特斯拉自动驾驶系统的名称)

在发生这起事故前,特斯拉的Autopilot已经累积了超过2亿公里的安全行驶里程。平均而言,美国范围内平均每1.5亿公里发生一起致死交通事故。从数字上来看,虽然Autopilot比人类驾驶员更安全,但机器致死还是值得我们深思的。

还原一场惨烈的事故

这起事故发生在今年5月7日中午,目前美国NHTSA正在调查之中,正式的调查结果还未公布。但根据特斯拉已公布的信息,我们还是能够还原部分事故发生时的情景的。

发生事故的车主叫做Joshua Brown,当时开着一辆Model S行驶在佛罗里达州的Williston。特斯拉曾明确提出,事故发生的时候车主开启了Autopilot功能。下面这张图是事故发生地的Google街景图。

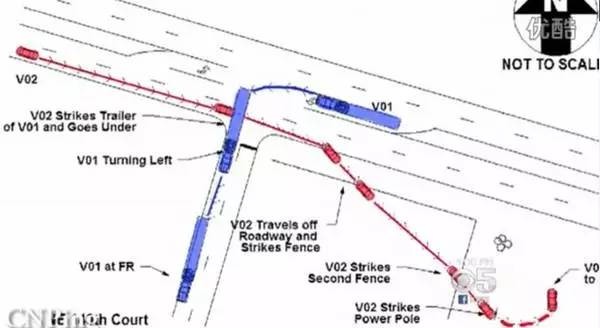

当时路口处有一辆卡车(官方的措辞是「tractor trailer」,即货柜+车头的结构),这辆卡车正在横穿马路。此时Model S正行驶在车道线内,处于自动驾驶状态,并和卡车呈接近垂直的方向。

由于特斯拉的Autopilot系统判断错误,车在毫无减速的情况下钻进了货柜下方。根据卡车司机的描述,事故发生后,Model S车里还在播放着「哈利波特」。(下图仅为tractor trailer车型示意图,并非事故车)

虽然没有现场事故照片,但我们也能脑补一下:一辆轿车钻进了货柜下方,脆弱的A柱瞬间断裂,车顶被削,车主当场死亡。在这场事故中,几个关键因素造成了这起事故,是偶然也是必然。

首先,这次卡车是横置的,摄像头很难从侧面识别一辆正在缓慢移动的卡车。另外,当天的佛罗里达州的阳光很强,卡车本身也有反光,可能导致Model S不能识别出卡车和天空。其次,卡车底盘很高,并且和Model S处于互相垂直的位置。Elon Musk说在这种情况下,车会以为是在通过安装在头顶的路牌,不会自动刹停。

无独有偶,在今年3月份的时候,一位车主在使用「召唤」功能时,车自己追尾了一辆大货车,撞坏了前挡风玻璃但没有人受伤。到底是谁的责任,还得扯皮一段时间。这么看来,特斯拉的Autopilot确实对各种各样的卡车不太感冒,所以提醒广大车主务必注意安全…

圈里人都怎么看?

关于特斯拉的这起事故,我和自动驾驶行业内的很多专家聊了聊,专业人士的观点很值得你一看。(部分人不方便透露公司和姓名,请谅解)

车和家CEO、汽车之家创始人李想:

(这段话取自他的微博,他本人也是资深特斯拉车主)

如果有激光雷达就可以避免了,摄像头为主的ADAS方案做自动驾驶还是有一定的缺陷,就是光线所造成的影响,包括更精准的距离判断,哪怕万分之一次的误判都是关乎生死的风险。

目前还只能解放手和脚,不能解放眼,车主们要正确使用,在Tesla上睡觉这种事情就别宣传了。

MINIEYE CEO刘国清:

这起事故可能是由以下的一个,或者几个「BUG」一起导致了这起悲剧:

1.为了更好的控制(「正常」工况下的)误检率和模型复杂度,Tesla使用的前向视觉感知系统(Mobileye提供)只能识别前车尾部,而不支持侧面车识别(注意,当时前方的挂车正处于转向状态,所以是侧面车身对着Tesla),于是导致视觉感知失效;

2.一般情况下,即便camera没有捕捉到,但radar也能够探测到前方障碍物的存在,但事故中挂车的底盘相对太高,同时Tesla上radar的安装位置又相对低,这种错位有可能导致radar对挂车的感知失败;

3.当然,还有一种可能性,事发时的特殊场景触发了sensorfusion机制中某种隐藏bug。

关于特斯拉的Autopilot,现在的过度宣传和广告都在告诉消费者这项技术有多智能,给大家造成这汽车已经可以自主驾驶的印象——但现在汽车行业大部分还处于1到2级,也就是需要人为干预,技术只能作为辅助。即便如Tesla这样的公司,离完全实现无人驾驶也还有一段距离。

在未来,驾驶无人化是必然的,只是比我们想象的要更慢。坦白说,我认为要实现完全的自动化驾驶一定会花超过10年的时间,甚至更久。因为这是一个异常庞大且复杂的系统,由很多个协同工作的子模块构成,而遗憾的是,其中相当一部分模块离成熟都还有不小的距离。在通往无人驾驶的道路,需要更多像Mobileye一样的公司,持久、专注的在自己的技术领域坚持。

奇点汽车CEO沈海寅:

此次特斯拉事故背后,对于自动驾驶汽车,舆论争议最多的一点,可能就是一旦这类车辆出现了交通安全事故,应该如何界定和划分责任,而在遇到道德层面暧昧不清时,我们也主张遵守法律为主。但在复杂的城市道路环境中,自动驾驶汽车因交通事故所带来的责任问题尚没有明确立法,自动驾驶汽车行驶规范与法律法规还基本上是空白,这是影响自动驾驶商业化最重要因素之一。

其实,自动驾驶汽车完全可以在不违规的情况下,机智地做出很多安全的决策,而做到这点,就离不开与人工智能技术的深入结合。这里我们可以举一下Alpha Go例子,TA突破了传统程序,搭建了两套模仿人类思维的深度卷积神经网络:value networks承担棋局态势评估,police networks选择如何落子。向人类棋手学习,从海量样本的胜局和败局中学,并自动提取规则,进行推理。

而自动驾驶让车辆做出合理判断的关键也同样在AI技术,智能系统是否可以利用人工智能技术让驾驶认知的形式化、并通过数据积累不断学习驾驶技能,最终替代驾驶员的感知、认知和行为。

拿森电子CEO/CTO陶喆:

这次事故不是三言两语就能够解释的,但「安全件」的开发,要符合相应的安全开发流程、安全标准。

安全件的开发最主要的不是功能的实现,而是实现产品的安全性和可靠性。在这方面,其实传统车企都是follow自己的设计规范、标准。在这一点上,特斯拉以及那些互联网造车公司还是很缺乏积累的。

这次事故,也是对新成立的主机厂、互联网造车团队的一次警示。传统车企在过去130多年积累的经验和知识,是他们最大的优势,传统车企的优势则是新兴车企的劣势。

另外,产品的安全性和可靠性应该是新兴主机厂花大量时间精雕细琢的。

某供应商辅助驾驶系统专家:

个人感觉这个是正常现象,首先驾驶员需要负主要责任,应该是驾驶员没有注意工况,而且Tesla只是减轻驾驶员驾驶负担而不是「托管」。

这里需要深究的问题是:Tesla如何对驾驶员的「行为」进行监控,除了手部之外是否还需要更多的监控,比如监控驾驶员的脸部,驾驶员是否睡觉,是否观看视频等。另外需要关注的就是驾驶员如果长时间未对车辆进行任何操作,在事故发生之前特斯拉是否有提醒驾驶员,以及系统退出机制是什么样的。

个人觉得,如果Tesla自身系统有一些限制的话(这个肯定存在,毕竟没有Li DAR以及V2X),那么当Autopilot系统无法应对该工况,必须要对驾驶员进行视觉、听觉或者是触觉的提醒,自己的系统在提醒之后也应该退出。

针对本次事故,对于毫米波雷达来说,缓慢移动的物体反射面复杂,反射点多;对于摄像头来说,因为这次卡车是横置的,而尾灯是判断车辆很重要的特征属性,所以有可能没有识别到,横向移动的卡车一般摄像头是不识别的。

中国工程院院士李德毅:

关于自动驾驶的安全性,李德毅院士今天在北京理工大学的一个讲座上也发表了自己的看法:

「因为驾驶活动充满不确定性,启用自动驾驶的窗口条件不能保证启用后仍然满足,窗口条件太脆弱,容易被打碎,随时要求驾驶员接管。自动驾驶表面上释放了人的手脚,但没有人的注意力,本质上是辅助不是自动,仍然是驾驶员担责。」

看了上面的这些说法,你就会发现起码在业内,大家还是主张驾驶员应该对车辆负责。目前来说,特斯拉虽然声称自己的Autopilot系统处于「Public betaphase(公开测试期)」,多次强调驾驶员双手要放在方向盘上,但是很多狂热的科技爱好者,依然选择过于相信机器。

这次发生事故的Joshua Brown就是其中之一,他非常喜欢特斯拉的Autopilot功能。在他的You Tube主页上,有很多关于火箭、波士顿动力机器人以及特斯拉的视频,其中就有他用行车记录仪拍摄到的Autopilot如何工作,避免车祸的视频。但是,这一次Autopilot没能拯救他的性命。

无论如何,机器毕竟是冰冷的,还是人在操纵,人类必须学会如何「正确」操纵这些机器。

-

引用 hebby 2016/7/5 21:23:45 发表于2楼的内容

-

引用 henryen 2016/7/10 10:24:38 发表于3楼的内容

-

引用 lanan 2016/7/10 14:12:48 发表于4楼的内容

-

-

-

-

lizhihua0907 | 当前状态:在线

总积分:1160 2025年可用积分:0

注册时间: 2011-09-01

最后登录时间: 2024-12-02

-

-

lizhihua0907 发表于 2016/7/11 10:38:08

5楼 回复本楼目前技术还不是很完善,自动驾驶未来一个发展方向

引用 lizhihua0907 2016/7/11 10:38:08 发表于5楼的内容

-